对谈耶鲁杨丰瑜:多模态AI引领具身智能革命

当今科技迅猛发展,人工智能(AI)已经成为改变各行各业的重要力量。从自动驾驶到智能助手,AI的应用无处不在。随着技术的不断进步,AI潜力也在不断扩大。

当前,AI的一个重要发展方向是多模态学习,即通过整合多种感官数据(如视觉、听觉、触觉)来提高机器的感知和理解能力。计算机视觉与触觉结合,是这一领域的重要课题。触觉提供了与视觉互补的信息,有助于机器在复杂环境中做出更准确的决策,是实现具身智能的关键一步。

由耶鲁大学计算机博士Fred Yang杨丰瑜主导,密歇根大学和耶鲁大学联合团队进行的研究,在人工智能的视觉-触觉领域迈出了重要一步。Fred杨丰瑜的研究重点,集中在计算机视觉与多模态大模型学习的交叉领域,尤其是视觉与触觉相结合。他研究的重点是具身认知,让机器人能够专注于从多感官观察中学习,并在环境中进行实时推理和认知发展。

Fred杨丰瑜介绍说:“人类对于物理世界的感知,很大一部分来源于视觉与触觉的结合。大数据的飞速发展,对多模态学习的其他领域产生了重要帮助,但是在视觉-触觉领域,由于采集数据的困难和不同传感器产生的非统一的触觉信号,这个方面的发展受到挑战。

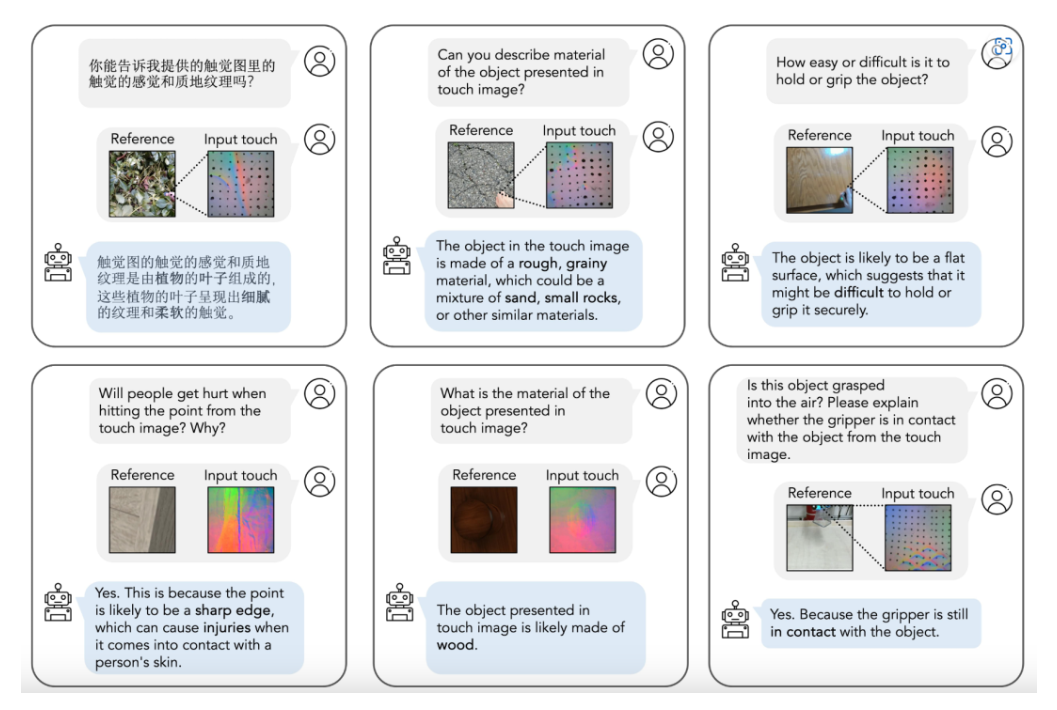

Fred杨丰瑜在具身智能领域做出的瞩目贡献,是提出了世界首个使用于多传感器的触觉大模型 UniTouch,适用于与视觉、语言和声音等多种模态相连的基于视觉的触觉传感器。从机器人抓取预测到触觉图像信号分析,UniTouch 能够在零样本环境下,执行各种触觉感知任务,是全球首个展示出这种能力的模型,为具身智能机器人的研发提供了重要支持,特别是在人形机器人领域。

杨丰瑜博士作为第一作者的UniTouch论文《Touch and Go: Learning from Human-Collected Vision and Touch》,被全球计算机视觉和模式识别领域的顶级会议CVPR (Conference on Computer Vision and Pattern Recognition)2024接收。在 Google Scholar 的学术会议 / 杂志排名中,CVPR 名列总榜第四,仅次于Nature、NEJM和Science。

杨丰瑜在人工智能、大数据和具身智能方面有丰富的积累和见解。他认为:随着数据量的爆发式增长,计算能力的不断提和算法技术的突破,多模态学习将成为AI发展的重要方向。通过整合视觉和触觉等多种感官信息,AI将能够更好地理解和适应复杂环境,从而实现更高水平的智能。Fred的研究成果不仅在学术界获得重要关注,也为具身智能,特别是人形机器人行业发展提供了重要支持。 他的工作展示了多模态学习在实现具身智能方面的巨大潜力。

他在对谈中指出,人工智能产业的发展方向清晰可见:多模态学习和具身智能将成为未来的重点领域,人类有理由相信,具身智能将为人类社会带来更高质量,更便捷的生活。特别是随着世界人口数量减少,人形机器人将有效承担家庭劳动,照顾老人,贴心陪伴,提升人类的生活质量。